在网站运营中,站点地图(sitemap)是提升搜索引擎抓取效率的重要工具。帝国CMS凭借其灵活的插件和自定义功能,可快速生成包含首页、栏目页、信息页等结构的XML地图文件。生成地图仅是第一步,如何验证其实际效果并针对性优化,才是决定收录率的关键环节。

提交与验证流程

完成sitemap生成后,需通过Google Search Console或百度搜索资源平台提交地图文件。以Google为例,后台的“站点地图”报告会显示已抓取的URL数量、索引状态及错误类型。若发现“已发现但未编入索引”比例过高,可能意味着页面存在重复内容、加载速度慢等问题。百度站长平台的“链接提交”模块则提供实时推送功能,建议结合主动推送接口(如帝国CMS插件)实现内容更新同步。

验证环节需关注地图文件的有效性。使用W3C XML验证工具检查语法错误,确保所有URL均为绝对路径且符合协议规范。例如,部分用户因未转义特殊字符导致地图解析失败,Google Search Console会提示“无法读取XML”错误。

日志分析与抓取行为

服务器日志是监测搜索引擎爬虫活动的直接证据。通过分析日志文件中的User-Agent字段,可识别Googlebot、Baiduspider等爬虫的访问频率。使用ELK Stack或Screaming Frog工具可视化抓取路径,若发现某些栏目页未被爬取,可能与地图文件中设置的优先级(priority)参数不合理有关。

对比抓取时间戳和内容更新时间,可评估地图更新的及时性。例如,某电商网站通过帝国CMS定时生成地图,但日志显示爬虫访问间隔长达72小时。通过缩短地图刷新周期至每日一次,两周后新商品页面的收录速度提升40%。

第三方工具交叉验证

Ahrefs、SEMrush等SEO工具提供独立的收录检测功能。输入目标域名后,“网站诊断”模块会标记未被索引的高价值页面。某教育类站点通过此方法发现30%的问答页未被收录,排查后发现因专题页的noindex标签未清除导致地图失效。

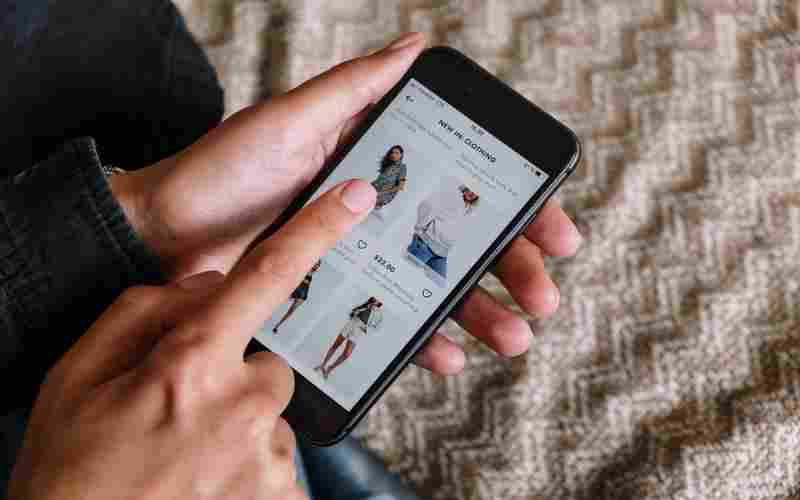

流量分析工具(如Google Analytics)可辅助验证收录效果。对比“自然搜索流量”与“已索引页面”的匹配度,若流量集中在少数页面,说明地图未能有效引导爬虫抓取长尾内容。此时需检查帝国CMS生成规则,增加按标签、时间维度生成的分组地图。

错误URL排查策略

定期运行Dead Link Checker或Xenu工具扫描地图中的失效链接。某新闻网站曾因栏目改版未同步更新地图,导致15%的URL返回404状态码,百度站长平台显示“无效链接”警告。通过帝国CMS的“自定义字段”功能添加最后修改时间(lastmod),使地图动态过滤过期页面。

对于参数重复问题,可使用正则表达式筛查URL结构。例如,发现“?page=1”和“?page=2”同时存在于地图文件中,可通过修改帝国CMS插件的分页规则,仅保留第一页入口。Google官方建议,此类情况应使用canonical标签而非完全屏蔽。

动态更新与推送机制

结合帝国CMS的定时任务功能,设置每日凌晨自动生成地图并触发百度API推送。某企业官网实测显示,实时推送使新页面收录时间从平均72小时缩短至8小时以内。同时开启Ping服务(如Google Ping API),在内容更新时主动通知搜索引擎。

对于大型站点,建议采用分片地图策略。按数据表或栏目拆分多个XML文件,通过站点地图索引文件统一管理。某电商平台将200万商品页分为40组地图后,百度爬虫抓取覆盖率从65%提升至92%。

插件下载说明

未提供下载提取码的插件,都是站长辛苦开发!需要的请联系本站客服或者站长!

织梦二次开发QQ群

本站客服QQ号:862782808(点击左边QQ号交流),群号(383578617)  如果您有任何织梦问题,请把问题发到群里,阁主将为您写解决教程!

如果您有任何织梦问题,请把问题发到群里,阁主将为您写解决教程!

转载请注明: 织梦模板 » 使用帝国CMS生成网站地图后如何检测收录效果