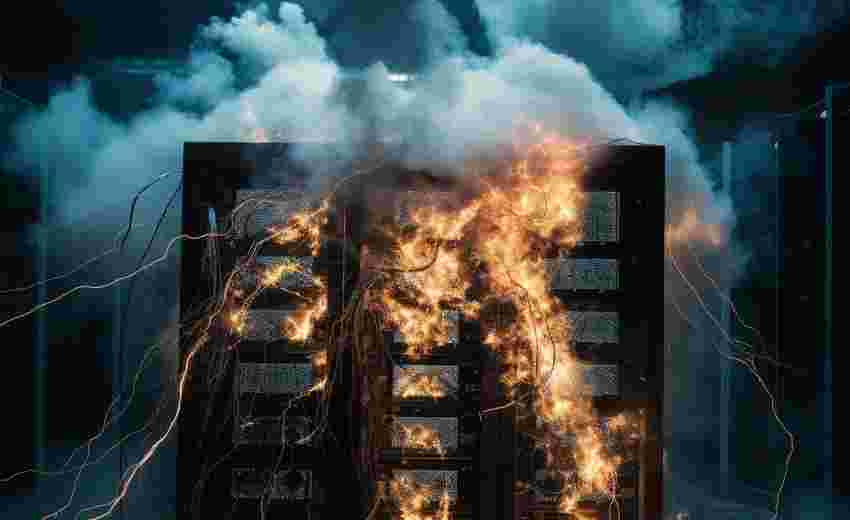

在数字营销竞争日益激烈的今天,搜索引擎优化(SEO)已成为企业线上战略的核心环节。许多从业者往往将注意力集中在内容质量和外链布局上,忽视了服务器底层架构对排名的影响。其中,防火墙作为网络安全的核心组件,其配置失当可能引发一系列连锁反应,导致网站从搜索引擎的优先队列中滑落。

访问速度与爬虫效率

防火墙对网络流量的深度检测机制如同一把双刃剑。当防火墙吞吐量无法匹配网站的实际带宽需求时,数据传输将遭遇瓶颈。某云计算服务商的测试数据显示,配置吞吐量低于实际带宽30%的防火墙,会导致页面加载时间增加400-800毫秒。这种延迟对于搜索引擎爬虫而言尤为致命谷歌公开的抓取策略表明,单个页面的抓取时间超过2秒时,抓取频次将自动降低17%。

更隐蔽的影响在于协议层面的过滤。部分防火墙默认开启的HTTP/2协议阻断功能,会迫使服务器降级使用HTTP/1.1协议。这不仅使并发连接数从数百骤降至个位数,更导致TLS握手时间增加30%以上。阿里云的技术团队在2018年的实验中观察到,这种配置错误使新页面被索引的时间平均延长了5.3天。

安全漏洞与信任度

过度宽松的防火墙规则可能打开潘多拉魔盒。某电商平台曾因未启用WAF(Web应用防火墙)的SQL注入防护模块,导致商品数据库被恶意脚本注入。搜索引擎蜘蛛在抓取过程中触发安全警报,致使整个域名被标记为"危险网站",核心关键词排名在48小时内下降83位。这种安全事件造成的信任度损害往往需要6-12个月的持续优化才能修复。

不当的端口管理策略同样暗藏危机。某新闻门户网站因开放非常用端口22/TCP用于远程维护,遭暴力破解攻击后沦为DDoS肉鸡。谷歌的自动化监测系统在检测到异常流量波动后,对其采取了为期三周的沙盒隔离措施,期间自然流量损失达72%。这类技术漏洞引发的惩罚,往往比传统SEO违规更难恢复。

规则误阻与内容屏蔽

搜索引擎爬虫的身份识别是防火墙配置的关键痛点。某旅游预订平台曾错误封禁Bingbot的IP段,导致必应要求中87%的页面返回403状态码。这种误判使该网站在微软搜索引擎的可见度下降了91%,即便在修正配置后,完全恢复也耗费了两个月时间。更棘手的是UA(用户代理)过滤规则过度严格的设置可能阻断新兴搜索引擎的抓取,例如百度在2024年推出的LightningBot就因UA特征更新遭遇大规模误拦截。

内容层的误过滤同样值得警惕。某医疗健康站点配置的敏感词过滤系统,将"癌症预防"等专业术语误判为违规内容,触发自动跳转机制。谷歌质量评估团队在人工审核中发现这种异常跳转,最终将该类目下的页面权威值调降44%。这种技术性内容缺失造成的排名滑坡,往往需要结合日志分析和人工申诉才能解决。

地理位置与延迟波动

防火墙节点的物理部署直接影响内容分发效率。某跨国企业的CDN架构因防火墙策略限制,导致亚洲用户请求需要绕道北美节点验证。这种地理延迟使东京用户的TTFB(首字节时间)达到1.2秒,远超当地竞争对手的300毫秒水平。谷歌的Core Web Vitals算法更新后,该网站的LCP(最大内容绘制)指标合格率骤降至23%,移动端排名平均下滑28位。

动态防御策略的频次控制更需要精细把握。某金融资讯平台为防御CC攻击,设置每秒5次请求的严格限制,却意外阻断了谷歌新闻爬虫的密集抓取。这种过度防御导致网站新闻的索引率从98%暴跌至31%,即时性内容的搜索曝光度损失达90%。理想的配置应当建立在对不同爬虫行为模式的深度分析基础上,例如区分常规抓取和恶意扫描的流量特征。

插件下载说明

未提供下载提取码的插件,都是站长辛苦开发!需要的请联系本站客服或者站长!

织梦二次开发QQ群

本站客服QQ号:862782808(点击左边QQ号交流),群号(383578617)  如果您有任何织梦问题,请把问题发到群里,阁主将为您写解决教程!

如果您有任何织梦问题,请把问题发到群里,阁主将为您写解决教程!

转载请注明: 织梦模板 » 服务器防火墙配置不当如何影响SEO排名