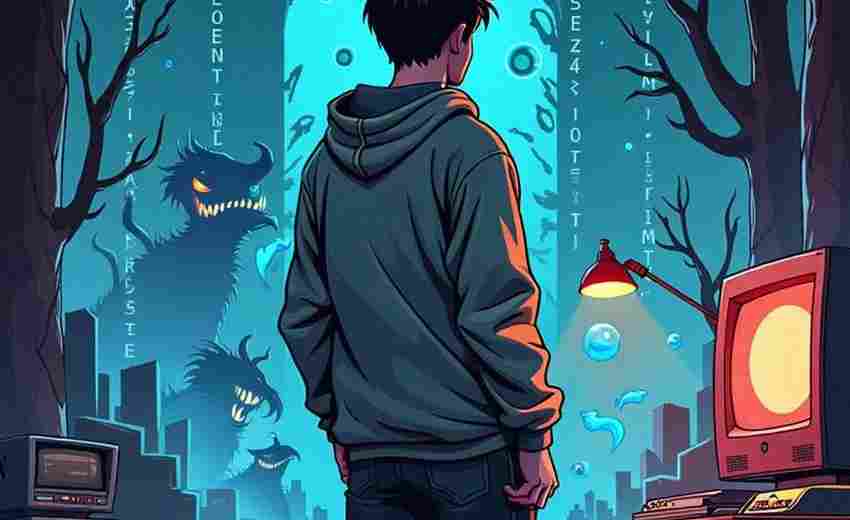

防止SEO蜘蛛劫持技术需要采取一系列的措施,以确保网站的安全性和搜索引擎的正常抓取。以下是一些有效的防范措施:

1. 加强服务器安全防护:确保服务器的安全性是防止蜘蛛劫持的基础。可以通过减少服务器权限、定期更新系统和软件、安装安全插件等方式来提高安全性。

2. 监控网站指数和异常流量:通过实时监控网站的各项指标,如访问量、跳出率等,可以及时发现异常情况。如果发现异常流量或索引异常,应立即进行调查和处理。

3. 使用杀毒软件和漏洞扫描工具:定期使用杀毒软件和漏洞扫描工具检查网站,以识别和删除潜在的木马文件或恶意代码。例如,检查是否存在global.asa文件,并将其重命名或删除。

4. 检查和验证蜘蛛访问:使用站长工具(如Google Search Console)进行模拟抓取测试,检查页面源代码和快照内容,确保没有被篡改或劫持。可以通过设置特定的用户代理(User-agent)来区分正常用户和搜索引擎蜘蛛。

5. 避免使用黑帽SEO技术:蜘蛛劫持通常与黑帽SEO技术相关联,因此避免使用这些技术是防止蜘蛛劫持的重要一步。例如,不要使用关键词堆砌、桥页、隐藏链接等手段。

6. 优化网站结构和内容:确保网站结构清晰,避免使用复杂的重定向和跳转机制。创建高质量的原创内容,减少被恶意篡改的风险。

7. 设置合理的robots.txt文件:通过合理设置robots.txt文件,控制搜索引擎蜘蛛的抓取权限,避免不必要的页面被收录。

8. 定期备份和恢复策略:定期备份网站数据,并制定恢复策略,以便在遭受攻击后能够迅速恢复网站的正常运行。

通过以上措施,可以有效防止SEO蜘蛛劫持技术对网站的影响,保障网站的安全性和搜索引擎的正常抓取。建议站长遵循白帽SEO原则,使用合法、透明的优化技术,以提高网站的长期排名和用户体验。

如何有效使用Google Search Console进行模拟抓取测试以检查网站是否被SEO蜘蛛劫持?

要有效使用Google Search Console(GSC)进行模拟抓取测试以检查网站是否被SEO蜘蛛劫持,可以按照以下步骤操作:

1. 登录Google Search Console:

访问Google Search Console的官方网站([) ),并使用您的Google账户登录。

2. 选择您的网站:

在登录后,选择您要检查的网站。如果您还没有添加网站,可以点击“添加资源”并按照提示完成添加。

3. 使用“网址检查”功能:

在Google Search Console的主界面中,找到并点击“网址检查”(Fetch as Google或新版的URL inspection tool)。这个功能可以帮助您模拟Google蜘蛛的行为,检查网页是否被正确抓取。

4. 输入要检查的URL:

在“网址检查”页面中,输入您想要检查的网页URL,然后点击“Fetch”按钮。这将模拟Google蜘蛛访问该页面,并返回抓取结果。

5. 查看抓取结果:

抓取完成后,您可以查看抓取结果页面。如果页面被正确抓取,您将看到页面内容的预览。如果存在抓取错误,如服务器错误、软404或其他问题,Google Search Console会提供详细的报告。

6. 检查抓取错误报告:

如果在抓取过程中遇到错误,Google Search Console会生成一个抓取错误报告。您可以查看这些报告,了解哪些页面存在抓取问题,并采取相应的措施进行修复。

7. 使用其他工具辅助检查:

除了Google Search Console,您还可以使用其他模拟蜘蛛抓取工具来进一步检查网站的安全性。例如,多UA模拟蜘蛛访问站点工具V3支持多种搜索引擎的PC和移动蜘蛛模拟,可以帮助您检测网站在不同搜索引擎下的表现。还可以使用专门的SEO综合诊断工具来模拟搜索引擎蜘蛛抓取页面,检查内容是否被预期一致。

8. 定期监控和维护:

定期使用Google Search Console和其他工具进行模拟抓取测试,可以帮助您及时发现和解决网站被SEO蜘蛛劫持的问题。保持网站的安全性和稳定性也是预防SEO劫持的重要措施。

SEO蜘蛛劫持的最新技术和方法有哪些?

根据提供的信息,无法回答关于SEO蜘蛛劫持的最新技术和方法的问题。我搜索到的资料主要集中在黑帽SEO技术及其风险,但没有详细描述最新的蜘蛛劫持技术或方法。例如, 提到了蜘蛛劫持的基本概念和一些传统方法,但没有提及最新的技术或方法。 和 提供了一些代码示例和实现方式,但这些内容也较为陈旧,未能反映当前的最新技术。

根据现有资料,无法提供关于SEO蜘蛛劫持的最新技术和方法的详细回答。

如何设置robots.txt文件以最大化保护网站免受SEO蜘蛛劫持?

要最大化保护网站免受SEO蜘蛛劫持,设置robots.txt 文件需要遵循以下步骤和最佳实践:

1. 创建并放置robots.txt 文件:

在网站根目录下创建一个名为“robots.txt ”的纯文本文件。

确保文件名统一为小写,以避免因大小写敏感问题导致文件无法被正确识别。

2. 指定用户代理(User-agent):

使用“User-agent: ”来允许所有搜索引擎蜘蛛抓取网站内容。

如果需要针对特定蜘蛛设置规则,可以使用具体的蜘蛛名称,如“User-agent: Googlebot”。

3. 禁止抓取特定目录或页面:

使用“Disallow”指令来禁止搜索引擎蜘蛛抓取特定的目录或页面。例如:

```

Disallow: /wp-admin/

Disallow: /wp-includes/

Disallow: /images/

Disallow: /data/

```

这些指令可以保护网站的后台管理文件、插件文件夹、图像文件和数据库文件等。

4. 允许抓取特定目录或页面:

使用“Allow”指令来允许搜索引擎蜘蛛抓取特定的目录或页面。例如:

```

Allow: /admin-ajax.php

```

这可以确保某些重要的页面或功能仍然可以被搜索引擎抓取。

5. 指定站点地图(Sitemap):

使用“Sitemap”指令来指定站点地图的位置,以便搜索引擎更好地了解网站结构和内容。例如:

```

Sitemap:

```

这有助于搜索引擎更高效地抓取和索引网站内容。

6. 设置爬行延迟(Crawl Delay):

使用“Crawl Delay”指令来限制搜索引擎蜘蛛的抓取频率。例如:

```

Crawl-delay: 10

```

这可以减少服务器负载,防止网站因大量蜘蛛抓取而崩溃。

7. 验证robots.txt 文件:

使用Google Search Console的Robots.txt 验证器或Google Robots.txt 解析器来确保语法正确且未意外阻止重要URL。

8. 集中管理robots.txt 文件:

对于每个域名和子域名,应有单独的robots.txt 文件。可以通过在子域名上托管robots.txt 文件并设置重定向,实现主域和子域的集中管理。

9. 避免常见错误:

确保每条Disallow行只能包含一个目录或文件。

避免误将重要页面禁止抓取,这可能会导致搜索引擎索引中缺失。

使用相对路径时要小心,确保路径正确无误。

使用哪些杀毒软件和漏洞扫描工具最有效于检测和删除网站上的恶意代码?

以下是一些最有效的杀毒软件和漏洞扫描工具,用于检测和删除网站上的恶意代码:

杀毒软件

1. ESET NOD32:ESET NOD32防病毒软件曾获得AV-Comparatives测试机构的“年度最佳反病毒产品”奖项,并连续51次通过VirusTotal的检测。

2. ClamAV:一个开源的杀毒软件,可以检测和删除恶意软件。

3. Dr.Web Antivirus:可以扫描和检测网页上的恶意代码,如病毒、蠕虫、特洛伊木马、广告软件、间谍软件和利用程序。

4. Kaspersky Antivirus:也是一个有效的杀毒软件,可以检测和清除恶意软件。

漏洞扫描工具

1. MalCare Vulnerability Scanner:这是最快的漏洞检测插件之一,可以识别新的和复杂的恶意软件,并提供自动扫描功能。

2. Sucuri SiteCheck:可以检测标记为“不安全”的链接和黑名单状态,但依赖于模式或签名匹配方法,可能无法检测到新的复杂恶意软件。

3. Quttera Website Scanner:可以提供恶意软件评估报告和检测Google和Yandex黑名单状态,但无法扫描大型网站。

4. UpGuard Web Scanner:可以进行30多项安全检查,评估网站的安全健康状况,但无法发现受感染的WordPress网站上存在的新的或复杂的恶意软件。

5. Google Malware Checker:一个免费在线恶意软件扫描工具,用于检测网站上的恶意软件。

WordPress专用工具

1. Wordfence:适用于WordPress网站,提供自动恶意软件扫描、每日邮件提醒、基本修复和删除功能,以及防火墙和双因素身份验证。

2. Jetpack Protect:免费插件,一键设置,每日自动扫描,由 背后的团队Automattic制作,适用于WordPress网站。

3. IsItWP Security Scanner:检查网站是否存在恶意软件和病毒,由Sucuri支持,通过输入URL扫描。

其他推荐工具

1. 元健恶意软件扫描器:覆盖超过4000种已知的恶意软件,可以发现专门针对网站应用设计的恶意软件,如Web壳/PHP Exploit。

2. Google安全浏览:通过简单的三步流程,即输入网站URL、点击“检查”按钮,即可生成安全报告,帮助用户了解网站是否安全。

这些工具各有其独特的优势和局限性,网站所有者应根据自身需求选择最适合的工具。

如何识别和避免使用黑帽SEO技术以防止SEO蜘蛛劫持?

识别和避免使用黑帽SEO技术以防止SEO蜘蛛劫持的方法如下:

1. 了解黑帽技术的定义与常见类型:

黑帽SEO是指那些违反搜索引擎指南的做法,旨在通过不正当手段获取更高的搜索引擎排名。常见的黑帽技术包括关键词堆砌、隐形文本、链接农场、内容抄袭、PR劫持、隐藏页面、隐藏锚文本、虚伪链接、欺骗点击链接等。

2. 掌握搜索引擎识别黑帽技术的机制:

搜索引擎如谷歌和百度利用复杂的算法和机器学习技术来评估网页的质量和相关性。这些算法能够监测关键词密度、分析网页样式表和HTML代码、识别低质量链接和用户行为数据,以判断网页质量和相关性。

3. 实施白帽SEO策略:

提供高质量、原创内容:确保网站内容有价值、原创且相关性强,以吸引用户和搜索引擎的关注。

合理使用关键词:避免过度堆砌关键词,保持自然的关键词分布。

优化网站结构和用户体验:确保网站结构清晰,导航简单,加载速度快,提高用户体验。

建设优质反向链接:通过内容营销、合作伙伴关系等方式获取高质量的反向链接。

利用社交媒体增强曝光度:通过社交媒体平台增加网站的曝光率和用户参与度。

定期分析和监测SEO表现:使用分析工具了解用户行为和流量来源,为后续的优化提供数据支持。

4. 避免使用黑帽技术的具体措施:

检查网页源代码:手动排查网页源代码,确保没有隐藏文字或链接。

避免使用301重定向作弊:不要通过大量网站网址301重定向到一个网站页面以获得大量权重。

不使用快照劫持和流量劫持技术:这些技术通过判断IP来模拟用户和蜘蛛,提供不同的内容和跳转,但会被搜索引擎识别并惩罚。

不创建虚假链接:避免创建虚假链接,链接内容与标题不符,欺骗搜索引擎。

5. 维护网站信誉和长期发展:

通过耐心和持续努力,结合高质量内容、优化用户体验和建立良好链接关系,网站的排名和信誉将得到显著提升。遵循搜索引擎的规范,实施合规的白帽SEO策略,才能在激烈的市场竞争中立于不败之地。

插件下载说明

未提供下载提取码的插件,都是站长辛苦开发!需要的请联系本站客服或者站长!

织梦二次开发QQ群

本站客服QQ号:862782808(点击左边QQ号交流),群号(383578617)  如果您有任何织梦问题,请把问题发到群里,阁主将为您写解决教程!

如果您有任何织梦问题,请把问题发到群里,阁主将为您写解决教程!

转载请注明: 织梦模板 » 如何防止SEO蜘蛛劫持技术?