在数字营销领域,SEO快速排名工具常被视为"流量密码",但鲜少有人揭示其背后的技术迷宫。当从业者试图绕过商业软件的高昂成本,选择独立研发或改造开源工具时,往往发现这条技术突围之路布满荆棘,从算法逻辑到数据合规的每个环节都暗藏挑战。

技术门槛高筑

构建有效的SEO工具首先需要跨越编程鸿沟。Python虽被称作"胶水语言",但涉及分布式爬虫架构时,开发者必须精通Scrapy框架的定制化开发,这对非科班出身者如同天堑。某开源社区调查显示,76%的SEO工具开发项目因无法解决动态渲染问题而夭折。

数据清洗环节更是技术深水区。当处理百万级关键词数据时,内存优化算法和分布式计算成为必修课。知名SEO工具Ahrefs工程师曾透露,他们的反向索引系统需要专门设计的压缩算法,才能将PB级数据压缩至可用存储空间。

算法迭代迅猛

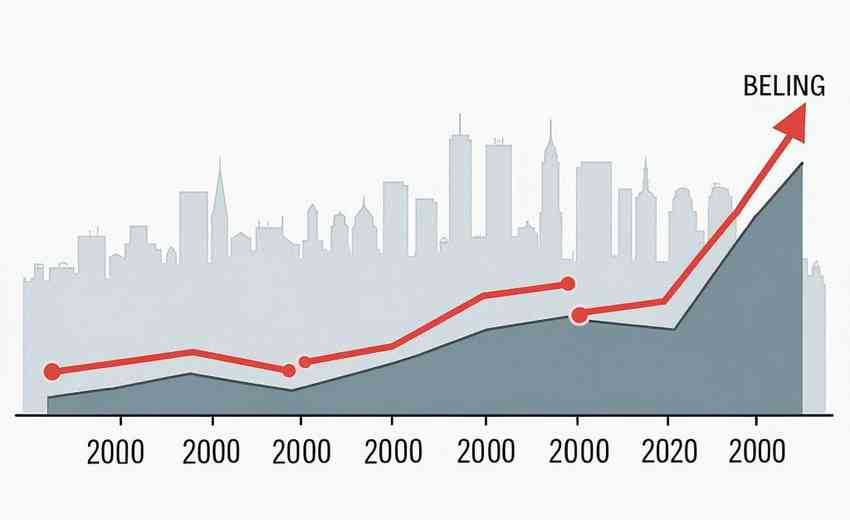

搜索引擎的排名机制如同移动靶标。2023年Google核心算法更新达9次,平均每40天就迭代规则。开源项目BrightEdge监测显示,62%的排名因子权重在季度内发生显著变化,这对自研工具的实时学习能力提出严苛要求。

用户意图解析是另一座技术高峰。当BERT算法主导搜索语义理解后,传统的关键词密度模型完全失效。微软研究院的论文指出,现代SEO工具必须集成NLP技术,才能准确捕捉"附近咖啡馆"与"咖啡馆装修"的语义差异。

数据获取困境

反爬虫技术的军备竞赛从未停歇。Cloudflare的5秒盾让多数自研爬虫折戟,而住宅代理的成本每月可达数万美元。某独立开发者尝试构建本地化SEO工具时,发现仅破解recaptcha验证系统就耗费三个月研发周期。

数据源的合法性边界日趋模糊。欧盟GDPR实施后,某德国团队因抓取本地企业信息被处以营收4%的罚款。更棘手的是,主流搜索引擎API的调用限制愈发严格,Google Search Console API的每日查询限额难以支撑工具化应用。

资源消耗巨大

硬件投入成为隐形杀手。模拟真实用户行为需要分布式IP池,AWS的t3.micro实例运行成本每月超2000美元。当处理长尾关键词时,内存数据库Redis集群的搭建成本呈指数级增长,这对个人开发者形成资金壁垒。

时间成本往往被严重低估。从原型开发到商业可用版本,SEMrush的工程日志显示其迭代周期长达18个月。即便是简单的排名追踪功能,也需要持续对接多个数据源,这对独立开发者的耐力构成考验。

法律风险潜伏

版权雷区遍布工具开发全程。抓取维基百科数据可能触犯知识共享协议,使用第三方字体库会遭遇DMCA警告。2022年美国法院判决某SEO工具赔偿120万美元,因其内置的模版系统涉嫌抄袭竞争对手的UI设计。

隐私保护红线不容逾越。加拿大CASL法案规定,收集邮箱地址必须获得双重确认。某跨境工具因自动提取LinkedIn联系人信息,导致开发者面临跨国诉讼。这些法律陷阱往往在代码写就时便已埋下,却在商业化阶段才突然爆发。

插件下载说明

未提供下载提取码的插件,都是站长辛苦开发!需要的请联系本站客服或者站长!

织梦二次开发QQ群

本站客服QQ号:862782808(点击左边QQ号交流),群号(383578617)  如果您有任何织梦问题,请把问题发到群里,阁主将为您写解决教程!

如果您有任何织梦问题,请把问题发到群里,阁主将为您写解决教程!

转载请注明: 织梦模板 » 自学SEO快速排名软件的难点有哪些