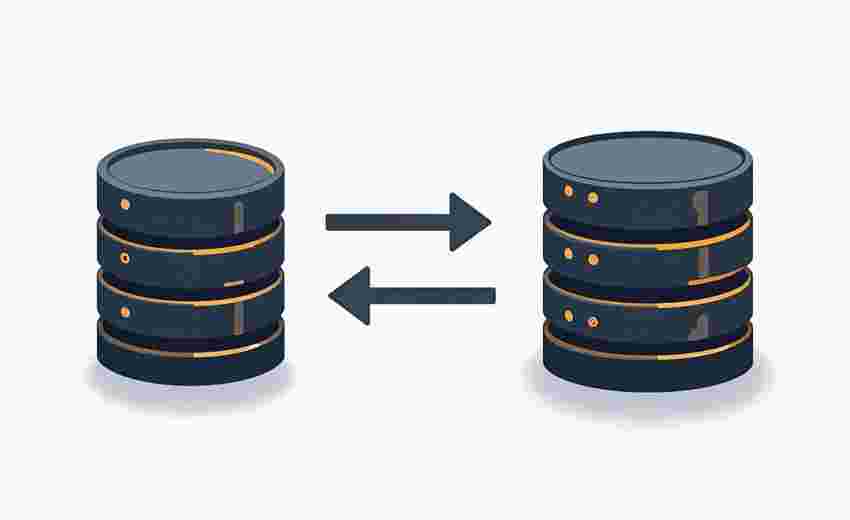

在网站迁移过程中,MySQL数据导入超时是运维人员常遇到的难题。这类问题往往由配置限制、网络波动或数据规模过大引发,导致迁移流程中断或效率低下。若不及时处理,可能延长业务中断时间,增加数据丢失风险。针对这类问题,需结合技术手段与操作策略进行系统性优化。

参数调优与配置适配

MySQL默认配置难以应对大规模数据迁移场景,核心参数的动态调整至关重要。通过修改`wait_timeout`(默认8小时)和`interactive_timeout`参数可延长空闲会话存活时间,、8均建议将其设为28800秒(8小时)。`max_allowed_packet`参数需要根据数据包大小调整至256M以上,避免大事务被截断。

第三方工具的配置限制常被忽视。如使用phpMyAdmin时需修改`$cfg['ExecTimeLimit']`参数突破300秒执行限制,该设置在程序配置文件而非php.ini中完成。对于阿里云等云数据库,还需关注ECS云服务器的云助手状态及网络ACL规则,确保数据传输通道畅通。

数据分块与导入策略

单次全量导入易触发超时机制,采用分批次处理可显著提升成功率。利用Linux系统的`split`命令按行切割SQL文件,例如`split -l 1000000 large_file.sql`生成百万行级片段文件。对于CSV等结构化数据,通过pandas等工具分块读取后分批写入,既能降低内存压力,又可避免单一事务过载。

事务管理与锁机制优化不可或缺。3建议临时关闭外键约束检查(`SET FOREIGN_KEY_CHECKS=0`),导入完成后重建索引。对于含自增主键的表,按主键排序后顺序写入可规避页分裂问题,实测效率提升可达40%。采用`LOAD DATA INFILE`替代INSERT语句,可使导入速度提升5-10倍。

传输通道与容错机制

网络层优化直接影响数据传输稳定性。通过SSH隧道执行`ssh user@remote 'mysql -u db_user < file.sql'`建立加密通道,比常规连接更抗干扰。使用`pv`工具限速(如`pv -L 10m data.sql | mysql`)可避免带宽峰值触发防火墙策略。阿里云SMC服务案例显示,确保源服务器具备公网访问能力并开放SSH端口是基础前提。

建立双阶段验证机制可有效降低回滚成本。首次导入后执行`CHECKSUM TABLE`校验数据完整性,利用`SHOW MASTER STATUS`记录binlog位置便于断点续传。5揭示,腾讯云DTS服务通过影子表对比技术保障迁移一致性,该方法同样适用于自建环境先创建镜像表进行数据比对,确认无误后再切换流量。

异常监控与应急处理

实时监控数据库线程状态是预防超时的关键。通过`SHOW PROCESSLIST`查看活跃线程,结合`information_schema.INNODB_TRX`表识别长事务。2建议将`innodb_lock_wait_timeout`从默认50秒调整为30秒,在OLTP场景中平衡响应速度与容错能力。

制定分级应急预案可最大限度缩短故障窗口。初级方案包含自动重试机制和日志解析工具,中级方案启用从库热备切换,高级预案则需触发全量备份恢复。5提供的错误码处理矩阵显示,针对ERROR 1205(锁超时)应优先kill阻塞进程,而ERROR 1227需检查账号权限体系。

插件下载说明

未提供下载提取码的插件,都是站长辛苦开发!需要的请联系本站客服或者站长!

织梦二次开发QQ群

本站客服QQ号:862782808(点击左边QQ号交流),群号(383578617)  如果您有任何织梦问题,请把问题发到群里,阁主将为您写解决教程!

如果您有任何织梦问题,请把问题发到群里,阁主将为您写解决教程!

转载请注明: 织梦模板 » 网站迁移时MySQL数据导入超时错误如何处理